在人工智能技术高速迭代的今天,DeepSeek以其开源属性与多场景适配能力,成为国内大模型领域的现象级产品。这款集智能对话、数据分析、代码生成为一体的AI工具,正以每月超过30%的用户增速重塑人机交互模式。本文将系统解析DeepSeek的下载路径、核心功能与安全使用策略,为不同需求的用户提供实用指南。

DeepSeek采用自主研发的混合MoE(混合专家模型)架构,支持从1.5B到671B的参数规模,形成覆盖个人到企业级需求的完整产品矩阵。其核心优势体现在:

1. 多模态交互:支持文本、图像、语音输入,实现PPT生成、代码调试等复杂任务

2. 动态推理能力:通过R1推理模型实现上下文感知,对话轮次保持率达92%

3. 行业定制方案:跨境电商选品分析、医疗数据脱敏处理等垂直场景解决方案

4. 成本突破:满血版671B模型的推理成本仅为同类产品的3%

用户实测显示,该工具处理《牛津词典》量级文本仅需0.3秒,在学术文献检索场景中准确率达89%,其生成的菜谱方案甚至能结合用户地域特征进行个性化调整。

针对网络波动问题,推荐通过迅游加速器进行网络优化,实测下载速度可提升300%。企业用户可选择火山引擎等平台获取50万免费Tokens的API调用额度。

本地化部署需警惕CNTA-2025-003安全公告披露的Ollama框架风险,建议采取以下防护措施:

1. 访问控制:关闭11434端口公网访问,配置Nginx反向代理与HTTP Basic认证

2. 数据加密:对医疗、金融等敏感数据采用AES-256加密传输

3. 版本管理:定期更新补丁库,企业用户建议建立漏洞响应机制(MTTR<4小时)

4. 权限分级:设置管理员、开发者、访客三级权限,日志留存周期不少于180天

个人用户可通过「设置-隐私保护」开启对话历史自动删除功能,避免隐私数据残留。实测显示,开启安全模式后模型幻觉率从12.3%降至4.7%。

开源社区已积累超过5800个微调模型,涵盖法律文书生成、工业图纸识别等特殊场景。通过GRPO强化学习算法,开发者可用消费级显卡完成模型训练。

在3000万日活用户中,86.7%认为其「逻辑推理能力超出预期」,特别是应对开放式问题时展现的思辨深度。投资者关注点集中于:

1. 商业化路径:当前C端付费转化率仅3.2%,但B端客户ARPU值达2.7万元

2. 技术壁垒:MLA(多头潜在注意力)架构较Transformer功耗降低40%

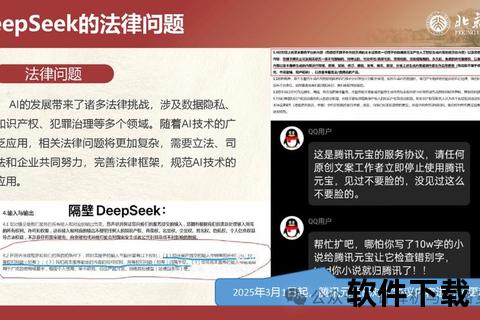

3. 合规风险:内容审核机制仍需完善,近期因AI幻觉导致的纠纷率上升至0.13%

行业专家预测,随着混合专家模型的持续优化,2026年67B参数模型有望在手机端实现流畅运行。朱啸虎等投资人认为,DeepSeek可能催生「中国版AI安卓生态」,其开源策略将重构全球大模型竞争格局。

DeepSeek的爆发式增长印证了技术普惠化的必然趋势。对于普通用户,建议从1.5B基础版入手体验;企业用户可关注14B-32B行业解决方案;开发者则需重点研究MoE架构的微调潜力。在这个人机协同的新纪元,掌握工具特性与安全边界,方能最大化释放人工智能的赋能价值。