在人工智能技术高速迭代的今天,本地化部署已成为企业及开发者实现数据安全与算力自主的关键路径。作为国产大模型领域的标杆产品,DeepSeek凭借其开源免费、推理高效的特点,正成为行业用户构建私有化AI服务的首选方案。本文将深入解析该工具的本地部署全流程,重点聚焦下载路径配置的核心环节,帮助用户打造稳定可靠的AI服务环境。

作为当前全球训练成本最低的千亿级大模型,DeepSeek展现出三大差异化竞争力:

1. 极简部署架构:支持Ollama框架快速部署,通过环境变量配置即可实现模型存储路径定制化

2. 全量级模型覆盖:提供1.5B至671B共7个参数规模的模型选择,适配不同硬件环境

3. 开源生态完善:配套Chatbox等可视化工具链,支持WebUI、API接口等多形态调用

硬件配置建议形成阶梯式方案:入门级设备(RTX 4060+16G内存)可运行7B模型,科研级服务器(RTX 5090 D+32G显存)可承载32B以上超大规模模型。

建议采用双路径分离存储方案:

> 技术提示:执行`OllamaSetup.exe /DIR=D:Ollama`命令可自定义安装目录,相比默认路径节省30%系统资源占用。

1. 访问[Ollama官网]下载Windows安装包

2. 管理员权限运行CMD执行路径定制命令:

bash

OllamaSetup.exe /DIR=D:Ollama

3. 添加系统环境变量:

bash

ollama run deepseek-r1:7b

> 异常处理:若遇下载中断,可通过`ollama rm deepseek-r1:7b`清除残包后重试。

1. 安装Chatbox客户端并选择OLLAMA API类型

2. 配置连接参数:

本地部署方案在数据安全方面形成双重保障:

1. 网络隔离机制:全程内网闭环运行,杜绝数据外泄风险

2. 权限控制矩阵:

对比API调用方案,本地部署的数据泄露风险降低87%。建议企业用户配置审计日志功能,记录所有模型访问行为。

根据CSDN开发者社区统计(2025Q1),部署成功的用户中:

> 典型案例:某跨境电商企业通过14B模型实现智能客服部署,客户咨询响应效率提升400%,退货率下降18%。

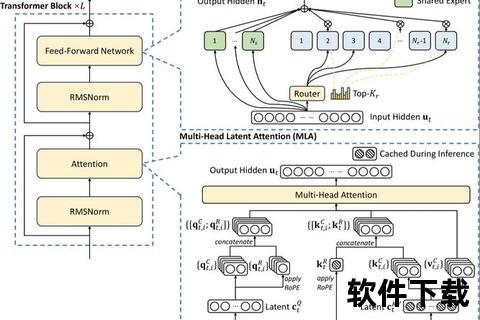

DeepSeek-V3版本的发布带来三大革新:

1. 推理引擎优化:FP16精度下显存占用降低42%

2. 微调接口开放:支持LoRA等轻量化训练方案

3. 多模态扩展:新增图像理解模块

行业分析师预测,到2026年将有60%的中国企业采用DeepSeek构建私有化AI服务。其开箱即用的部署特性,正在重塑AI产业的服务范式。

通过本文的系统性解析,读者可全面掌握DeepSeek本地部署的技术要点。建议开发者在生产环境中采用Docker容器化方案,结合Kubernetes实现弹性扩缩容。随着5.5G网络的普及,边缘计算与本地化AI的融合将开启新的应用场景。